转载文章,写的很有启发:

原文链接:https://mp.weixin.qq.com/s/NMW2p8xalh9c8lTLN9B5gg%3Fmpshare%3D1%26amp%3Bscene%3D1%26amp%3Bsrcid%3D020804xdTWteivkorqNNCh ... D1%23wechat_redirect

**Insight 01

DeepSeek 超越 OpenAI 了吗?**

DeepSeek 超越了 Meta Llama 毫无疑问,但相比 OpenAI、Anthropic 和 Google 这些第一梯队 players 还有距离,比如 Gemini 2.0 Flash 成本比 DeepSeek 更低,能力也很强,且全模态,外界低估了 Gemini 2.0 为代表的第一梯队的能力,只是没有开源而获得这么炸裂轰动性的效果。

DeepSeek 很让人兴奋,但还不能称作范式级创新,更准确的表述是将之前 OpenAI o1 半遮半掩的范式开源,将整个生态推向很高渗透率。

从第一性原理角度,在 Transformer 这一代架构下超越第一梯队模型厂商是有难度的,同样路径下很难实现弯道超车可能,今天更期待有人能探索出下一代的智能架构和范式。

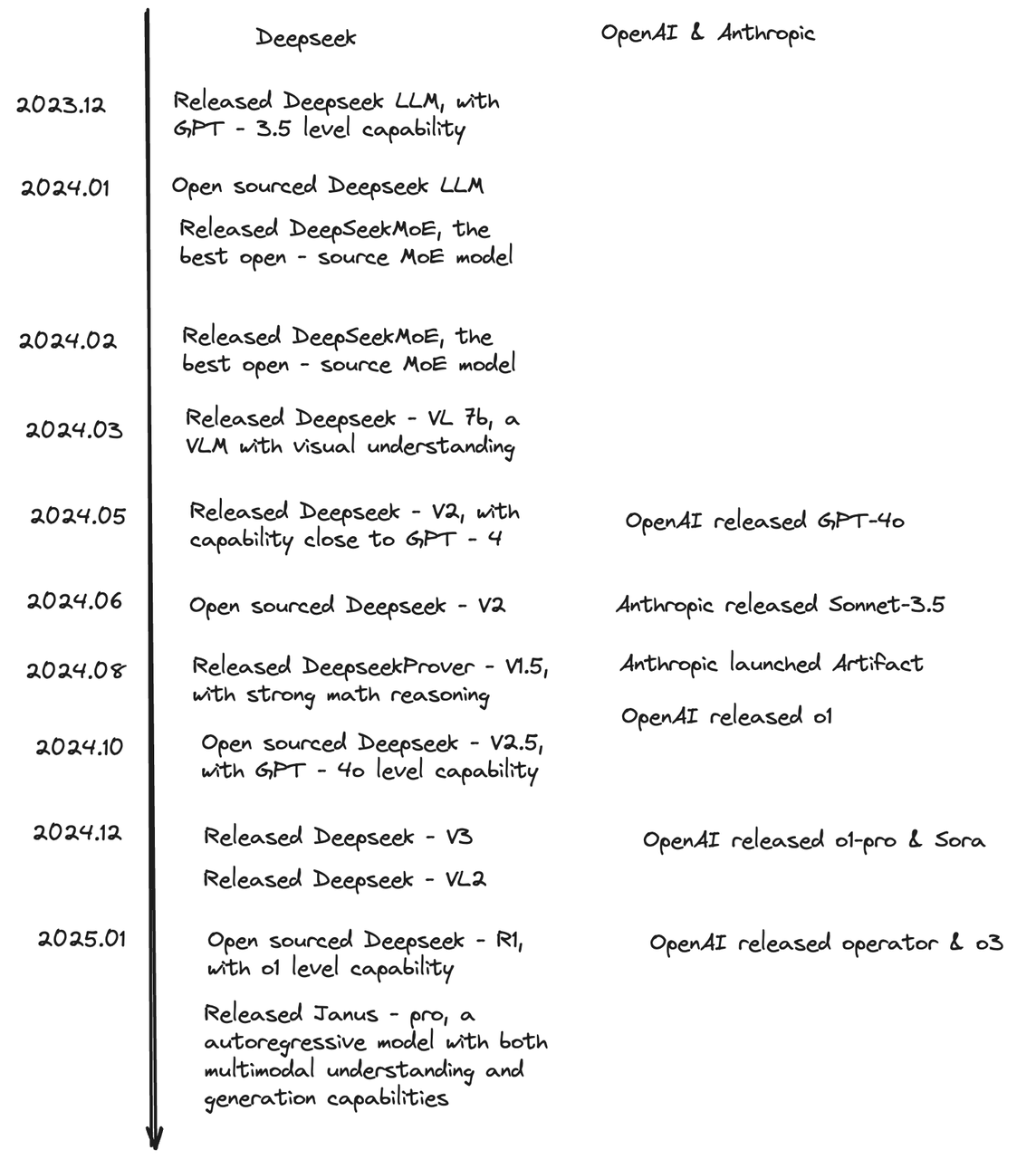

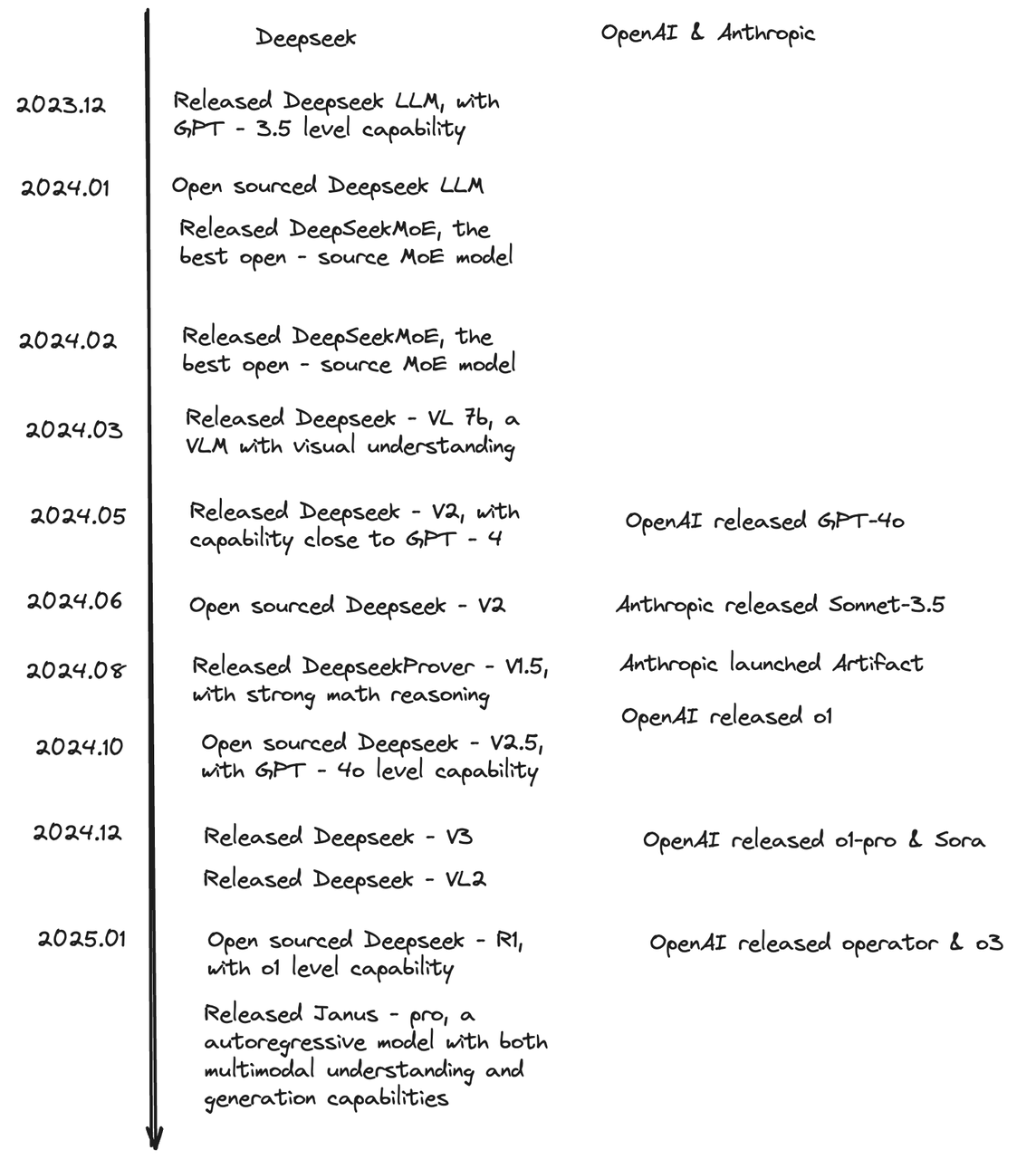

DeepSeek 用一年时间

追上了 OpenAI 和 Anthropic

**Insight 02

DeepSeek 开启新范式了吗?**

就像前面说的,严格意义上说,DeepSeek 没有发明新范式。

但 DeepSeek 的重要意义在于帮助 RL 和 test time compute 这个新范式真正出圈。如果说 OpenAI 最初发布的 o1 是给行业出了一个谜语,DeepSeek 就是第一个公开解谜的人。

DeepSeek 发布 R1 和 R1-zero 之前,行业只有少部分人在实践 RL 和 reasoning model,但 DeepSeek 给大家指明了路线图,让行业相信这样做真的能提升智能,这对提升信心,吸引更多 AI researcher 转向新范式的研究有巨大的帮助。

有人才进入,才有算法创新,有开源紧追才有更多计算资源投入。在 DeepSeek 之后,原本计划不再发新模型的 OpenAI 接连发出 o3mini,并计划继续发布 o3,还考虑开源模型。Anthropic 和 Google 也会加快 RL 的研究。行业对新范式的推进因为 DeepSeek 加快,中小团队也可以在不同的 domain 上尝试 RL。

另外,reasoning model 的提升会进一步帮助 agent 落地,AI researcher 现在都因此对 agent 的研究和探索更有信心,因此也可以说 DeepSeek 开源 reasoning model 推进了行业向 Agent 的进一步探索。

所以 DeepSeek 虽然没有发明新范式,但推进整个行业进入了新范式。

**Insight 03

Anthropic 的技术路线和 R1 有什么不同?**

从 Dario的访谈可以看出,Anthropic对R-1/reasoning model的理解,与O系列有些分歧,Dario觉得 base model 与 reasoning model应该是个连续光谱,而非 OpenAI 这种独立的模型系列。如果只做 O 系列会很快遇到天花板。

我一直想为什么 Sonnet 3.5的coding、reasoning 和 agentic能力一下子提升这么强,但 4o 一直没追上?

他们在 pre training base model 阶段就做了大量 RL 工作,核心还是把 base model 提上去,不然只靠 RL 提升 reasoning model 可能很容易把收益吃光。

**Insight 04

DeepSeek 的轰动有必然,也有偶然**

两位早期 OpenAI 研究员写的《为什么伟大不能被计划》形容 DeepSeek 也很合适。

技术角度上,DeepSeek 有下面几个亮点:

• 开源:开源这点很重要,OpenAI 从 GPT-3 开始转为闭源公司后,第一梯队三巨头就不再公开技术细节,拱手让出了一个空白的开源生态位,但 Meta 和 Mistral 并没有接稳这个位置,DeepSeek 这次堪称奇袭,在开源这块大赛道一马平川。

如果把轰动性打 100 分,智能提升贡献 30 分,开源贡献 70 分,之前 LLaMA 也开源但没有这么轰动的效果,说明 LLaMa 智能水平不够。

• 便宜:“Your margin is my opportunity” 这句话的含金量还在上升。

• 联网+公开 CoT:对于用户这两个点分别都能带来很好的用户体验,DeepSeek 把两张牌同时出了,可以说是王炸,给到 C 端用户的体验和其他 Chatbot 完全不一样。尤其是 CoT 透明,把模型思考过程公开了,透明能让用户对 AI 更信任,促进了破圈。不过,按理说 Perplexity 也是冲击很大的,但 DeepSeek 服务端不稳定,Perplexity 团队快速反应上线了 R-1 反而承接了很大 DeepSeek R-1 溢出的用户。

• RL 泛化:虽然 RL 是 OpenAI o1 最先提出来的,但因为各种运营一直半遮半掩,渗透率并不高,DeepSeek R-1 很大意义推动了 reasoning model 范式的进程,生态接受度大幅提升。

DeepSeek 在技术上的探索投入是被这个智能成果值得更多人关注、讨论的确定性因素,但 DeepSeek R1 推出的 timing 又让这场轰动带有偶发性:

• 过去美国一直讲自己在基础技术研究上大幅领先,但 DeepSeek 原生于中国国内,这本身也是一个亮点,这个过程中,又有很多美国科技大佬开始去宣扬 DeepSeek 挑战了美国科技霸主的地位的论调,DeepSeek 属于被动卷进舆论战;

• DeepSeek R1 发布之前,OpenAI Stargate $500B 事件刚刚开始发酵,这种巨量投入和 DeepSeek 团队智能产出效率对比太鲜明了,很难不引发关注、讨论;

• DeepSeek 让英伟达股价大跌又进一步让舆论发酵,他们肯定也想不到自己成为了 2025 开年美股第一只黑天鹅;

• 春节是产品的练兵场,移动互联网时代很多超级 App 都是在春节大爆发的,AI 时代也不例外。DeepSeek R1 恰好在春节前发布,大众惊喜的是它的文字创作能力,而不是训练时候强调的 coding 和数学能力,文创更容易被大众用户有体感,也更容易 go viral。

**Insight 05

谁受伤?谁受益?**

可以把这个赛场上的 players 分 3 类:ToC、To Developer 以及 To Enterprise( to Government):

再换个角度,从闭源、开源和算力的视角想这个问题:

短期大家会觉得闭源的 OpenAI/Anthropic/Google 更受冲击:

• 技术神秘感被开源了,AI hype 里面最重要的神秘感的溢价被打破;

• 更现实的因素,市场认为这几家闭源公司的潜在客户和市场规模被抢走了一些,GPU 投入的回本周期变长;

• 作为领头羊的 OpenAI 在其中属于最“吃亏”的那个,之前想捂着技术不开源,半遮半掩,希望多赚技术溢价的美梦无法实现了。

但中长期看,GPU 资源充裕的公司还是受益的,一方面是第二梯队的 Meta 可以快速跟进新方法,Capex 更加 efficient,Meta 可能是很大受益者,另一方面是智能提升还需要更多探索,DeepSeek 开源把大家水平拉齐,进入全新探索又需要 10 倍甚至更大量级的 GPU 投入。

从第一性原理来想,对于 AI 智能产业来说,无论是发展智能还是应用智能,从物理本质上就必然要消耗海量算力,这是基础定律决定的,不是技术优化能完全规避的。

所以,无论是探索智能,还是应用智能,即便短期有质疑,中长期的算力需求也会爆炸,这也解释了为什么马斯克从第一性原理出发,xAI 坚持扩建集群,xAI 和 Stargate 背后的深层逻辑也许是一样的。Amazon 等云厂商都宣布了要增加 Capex 指引。

我们就假设全球的 AI research 人才水平和认知都拉齐,有更多 GPU 就可以做更多实验探索?最后可能还是回到 compute 的竞争。

DeepSeek 光脚不怕穿鞋,没有商业化诉求,专注 AGI 智能技术探索,开源这个动作对推动 AGI 进程推动意义很大,加剧了竞争,推动了开放性,颇有鲶鱼效应。

**Insight 06

蒸馏能超越 SOTA 吗?**

有个细节点不确定,如果 DeepSeek 从 pre train 阶段就大量使用蒸馏的 CoT 数据,那做到今天效果不算惊艳,还是在第一梯队巨头的肩膀上获得的基础智能,然后再开源出来;但如果 pre train 阶段没有大量用蒸馏数据,DeepSeek 从 0 做 pre train 做到今天的效果,那就堪称惊艳了。

另外,蒸馏能否在 base model 超越 SOTA,应该是不太可能的。但 DeepSeek R-1 非常强,猜测是 Reward model 做的非常好,如果 R-1 Zero 这条路径靠谱,是有机会超越 SOTA。

**Insight 07

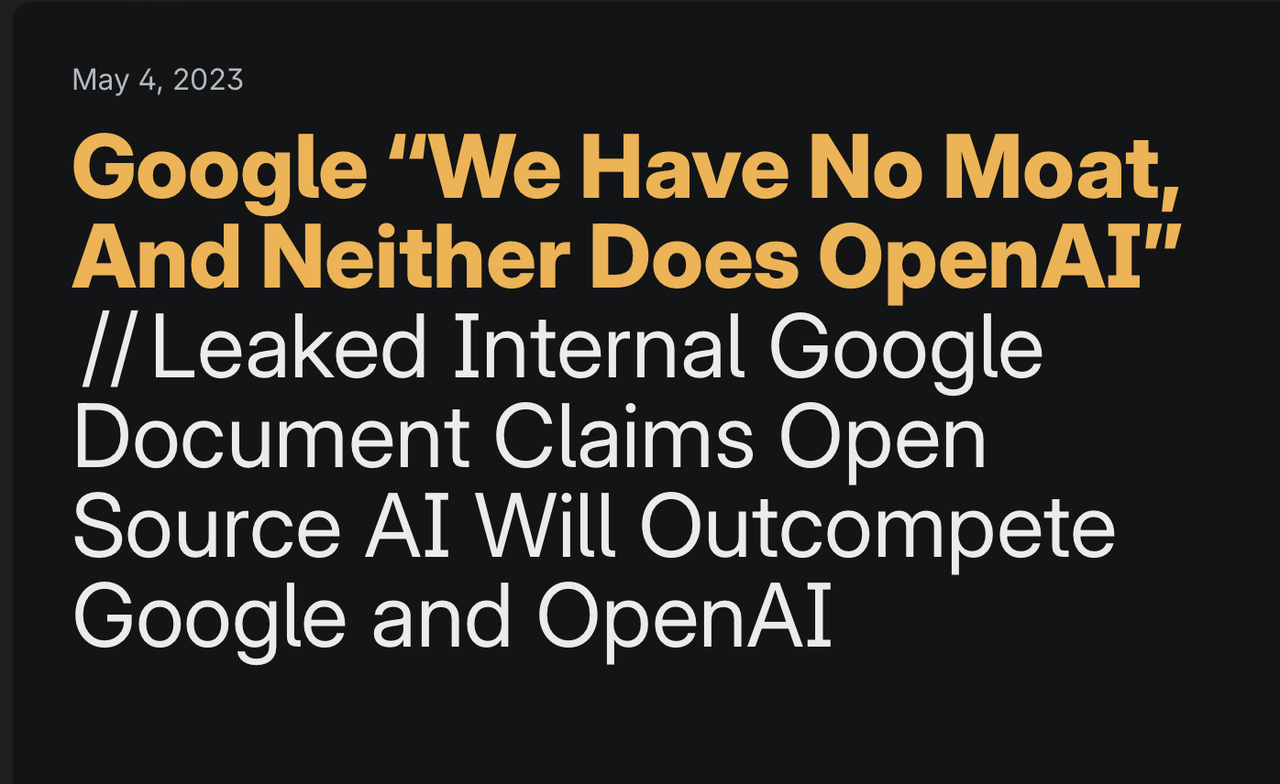

No Moat !**

Google 之前对 OpenAI 的一个评价:No Moat!这句话放在这里也很应景。

DeepSeek 这一波 Chatbot 用户又出现了大量迁移现象,给了市场一个很重要的启发:智能技术进步非常陡峭,阶段性产品很难形成绝对壁垒。

不管是 ChatGPT/Sonnet/Perplexity 刚形成了心智和口碑,还是 Cursor、Windsurf 这类开发者工具,一旦有了更智能的产品,用户对“上一代”智能的产品毫无忠诚度,今天不管是模型层还是应用层都很难构建护城河。

DeepSeek 这次也验证了一件事:模型即应用,DeepSeek 在产品形式上没任何创新,核心就是智能+开源,我也不禁思考:在 AI 时代,任何产品和商业模式的创新都比不上智能的创新吗?

**Insight 08

DeepSeek 应该承接

这波 Chatbot 流量并做大吗?**

从 Chatbot 爆火到今天,通过 DeepSeek 团队的反应可以明显感觉出来,DeepSeek 还没想好怎么用这波流量。

而要不要接住、并积极运营这批流量这个问题的本质是,伟大的商业公司和伟大的 research lab 能共存在一个组织吗?

这件事非常考验精力和资源分配、组织能力和战略选择,如果是字节、Meta 这类大公司,他们的第一反应应该都要接下来,也有一定组织基础可以接下来,但 DeepSeek 作为一个 research lab 组织,承接这波巨量流量的压力必然很大。

但同时也要想这一波 Chatbot 会是阶段性流量吗?Chatbot 是不是在未来智能探索的主线下?似乎感觉每个智能阶段都有对应的产品形态,而 Chatbot 只是解锁的其中一个早期形态。

对于 DeepSeek 来说,从未来 3-5 年视角看,如果今天不去承接 Chatbot 流量,会不会是一种 miss?万一哪天跑出规模效应?如果 AGI 最终实现了,又会是什么载体来承接?

**Insight 09

下一个智能突破的 Aha moment 从哪来?**

一方面,第一梯队的下一代模型很关键,但今天我们又处在 Transformer 的极限边界上,第一梯队能否拿出代际提升的模型也不确定。OpenAI、Anthropic 和 Google 作为回应发出来好 30-50%的模型可能都不够挽回局势,因为他们资源多了 10-30 倍。

另一方面, Agent 落地比较关键,因为 Agent 需要做长距离多步骤推理,如果模型好 5-10%,领先的效果就会被放大很多倍,所以 OpenAI、Anthropic 和 Google 一方面要做 Agent 产品落地,full stack 集成模型+Agent 产品,就像 Windows+Office,二是也要 show 出来更强大的模型,比如 O3 完整版、Sonnet 4/3.5 opus 为代表的下一代模型。

在技术不确定性下,最宝贵的是天才 AI researchers,任何想要探索 AGI 的组织都要投入资源更激进的 bet on next paradigm,尤其是在今天 pre training 阶段已经被拉齐的背景下,要有好的人才+充裕资源,探索下一个智能涌现的 Aha moment。

**Insight 10

DeepSeek 这一波让我对

中国 AI 人才更有信心,非常鼓舞**

**

最后,希望技术无国界。**

原文链接:https://mp.weixin.qq.com/s/NMW2p8xalh9c8lTLN9B5gg%3Fmpshare%3D1%26amp%3Bscene%3D1%26amp%3Bsrcid%3D020804xdTWteivkorqNNCh ... D1%23wechat_redirect

**Insight 01

DeepSeek 超越 OpenAI 了吗?**

DeepSeek 超越了 Meta Llama 毫无疑问,但相比 OpenAI、Anthropic 和 Google 这些第一梯队 players 还有距离,比如 Gemini 2.0 Flash 成本比 DeepSeek 更低,能力也很强,且全模态,外界低估了 Gemini 2.0 为代表的第一梯队的能力,只是没有开源而获得这么炸裂轰动性的效果。

DeepSeek 很让人兴奋,但还不能称作范式级创新,更准确的表述是将之前 OpenAI o1 半遮半掩的范式开源,将整个生态推向很高渗透率。

从第一性原理角度,在 Transformer 这一代架构下超越第一梯队模型厂商是有难度的,同样路径下很难实现弯道超车可能,今天更期待有人能探索出下一代的智能架构和范式。

DeepSeek 用一年时间

追上了 OpenAI 和 Anthropic

**Insight 02

DeepSeek 开启新范式了吗?**

就像前面说的,严格意义上说,DeepSeek 没有发明新范式。

但 DeepSeek 的重要意义在于帮助 RL 和 test time compute 这个新范式真正出圈。如果说 OpenAI 最初发布的 o1 是给行业出了一个谜语,DeepSeek 就是第一个公开解谜的人。

DeepSeek 发布 R1 和 R1-zero 之前,行业只有少部分人在实践 RL 和 reasoning model,但 DeepSeek 给大家指明了路线图,让行业相信这样做真的能提升智能,这对提升信心,吸引更多 AI researcher 转向新范式的研究有巨大的帮助。

有人才进入,才有算法创新,有开源紧追才有更多计算资源投入。在 DeepSeek 之后,原本计划不再发新模型的 OpenAI 接连发出 o3mini,并计划继续发布 o3,还考虑开源模型。Anthropic 和 Google 也会加快 RL 的研究。行业对新范式的推进因为 DeepSeek 加快,中小团队也可以在不同的 domain 上尝试 RL。

另外,reasoning model 的提升会进一步帮助 agent 落地,AI researcher 现在都因此对 agent 的研究和探索更有信心,因此也可以说 DeepSeek 开源 reasoning model 推进了行业向 Agent 的进一步探索。

所以 DeepSeek 虽然没有发明新范式,但推进整个行业进入了新范式。

**Insight 03

Anthropic 的技术路线和 R1 有什么不同?**

从 Dario的访谈可以看出,Anthropic对R-1/reasoning model的理解,与O系列有些分歧,Dario觉得 base model 与 reasoning model应该是个连续光谱,而非 OpenAI 这种独立的模型系列。如果只做 O 系列会很快遇到天花板。

我一直想为什么 Sonnet 3.5的coding、reasoning 和 agentic能力一下子提升这么强,但 4o 一直没追上?

他们在 pre training base model 阶段就做了大量 RL 工作,核心还是把 base model 提上去,不然只靠 RL 提升 reasoning model 可能很容易把收益吃光。

**Insight 04

DeepSeek 的轰动有必然,也有偶然**

两位早期 OpenAI 研究员写的《为什么伟大不能被计划》形容 DeepSeek 也很合适。

技术角度上,DeepSeek 有下面几个亮点:

• 开源:开源这点很重要,OpenAI 从 GPT-3 开始转为闭源公司后,第一梯队三巨头就不再公开技术细节,拱手让出了一个空白的开源生态位,但 Meta 和 Mistral 并没有接稳这个位置,DeepSeek 这次堪称奇袭,在开源这块大赛道一马平川。

如果把轰动性打 100 分,智能提升贡献 30 分,开源贡献 70 分,之前 LLaMA 也开源但没有这么轰动的效果,说明 LLaMa 智能水平不够。

• 便宜:“Your margin is my opportunity” 这句话的含金量还在上升。

• 联网+公开 CoT:对于用户这两个点分别都能带来很好的用户体验,DeepSeek 把两张牌同时出了,可以说是王炸,给到 C 端用户的体验和其他 Chatbot 完全不一样。尤其是 CoT 透明,把模型思考过程公开了,透明能让用户对 AI 更信任,促进了破圈。不过,按理说 Perplexity 也是冲击很大的,但 DeepSeek 服务端不稳定,Perplexity 团队快速反应上线了 R-1 反而承接了很大 DeepSeek R-1 溢出的用户。

• RL 泛化:虽然 RL 是 OpenAI o1 最先提出来的,但因为各种运营一直半遮半掩,渗透率并不高,DeepSeek R-1 很大意义推动了 reasoning model 范式的进程,生态接受度大幅提升。

DeepSeek 在技术上的探索投入是被这个智能成果值得更多人关注、讨论的确定性因素,但 DeepSeek R1 推出的 timing 又让这场轰动带有偶发性:

• 过去美国一直讲自己在基础技术研究上大幅领先,但 DeepSeek 原生于中国国内,这本身也是一个亮点,这个过程中,又有很多美国科技大佬开始去宣扬 DeepSeek 挑战了美国科技霸主的地位的论调,DeepSeek 属于被动卷进舆论战;

• DeepSeek R1 发布之前,OpenAI Stargate $500B 事件刚刚开始发酵,这种巨量投入和 DeepSeek 团队智能产出效率对比太鲜明了,很难不引发关注、讨论;

• DeepSeek 让英伟达股价大跌又进一步让舆论发酵,他们肯定也想不到自己成为了 2025 开年美股第一只黑天鹅;

• 春节是产品的练兵场,移动互联网时代很多超级 App 都是在春节大爆发的,AI 时代也不例外。DeepSeek R1 恰好在春节前发布,大众惊喜的是它的文字创作能力,而不是训练时候强调的 coding 和数学能力,文创更容易被大众用户有体感,也更容易 go viral。

**Insight 05

谁受伤?谁受益?**

可以把这个赛场上的 players 分 3 类:ToC、To Developer 以及 To Enterprise( to Government):

- ToC:Chatbot 肯定受冲击最大,心智和品牌关注度被 DeepSeek 抢走了,ChatGPT 也不例外;

- 在开发者环节的影响很有限,我们看到有用户用完之后说评论 r1 不好用不如 sonnet,Cursor 官方也说 Sonnet 还是 outperform,用户 surprisingly 高比例都选择 Sonnet,并没有大幅迁移;

- 第三个维度,To Enterprise 和 To Government 的生意在于信任和需求理解,大型组织做决策的利益考虑很复杂,不会像 C 端用户那么容易迁移。

再换个角度,从闭源、开源和算力的视角想这个问题:

短期大家会觉得闭源的 OpenAI/Anthropic/Google 更受冲击:

• 技术神秘感被开源了,AI hype 里面最重要的神秘感的溢价被打破;

• 更现实的因素,市场认为这几家闭源公司的潜在客户和市场规模被抢走了一些,GPU 投入的回本周期变长;

• 作为领头羊的 OpenAI 在其中属于最“吃亏”的那个,之前想捂着技术不开源,半遮半掩,希望多赚技术溢价的美梦无法实现了。

但中长期看,GPU 资源充裕的公司还是受益的,一方面是第二梯队的 Meta 可以快速跟进新方法,Capex 更加 efficient,Meta 可能是很大受益者,另一方面是智能提升还需要更多探索,DeepSeek 开源把大家水平拉齐,进入全新探索又需要 10 倍甚至更大量级的 GPU 投入。

从第一性原理来想,对于 AI 智能产业来说,无论是发展智能还是应用智能,从物理本质上就必然要消耗海量算力,这是基础定律决定的,不是技术优化能完全规避的。

所以,无论是探索智能,还是应用智能,即便短期有质疑,中长期的算力需求也会爆炸,这也解释了为什么马斯克从第一性原理出发,xAI 坚持扩建集群,xAI 和 Stargate 背后的深层逻辑也许是一样的。Amazon 等云厂商都宣布了要增加 Capex 指引。

我们就假设全球的 AI research 人才水平和认知都拉齐,有更多 GPU 就可以做更多实验探索?最后可能还是回到 compute 的竞争。

DeepSeek 光脚不怕穿鞋,没有商业化诉求,专注 AGI 智能技术探索,开源这个动作对推动 AGI 进程推动意义很大,加剧了竞争,推动了开放性,颇有鲶鱼效应。

**Insight 06

蒸馏能超越 SOTA 吗?**

有个细节点不确定,如果 DeepSeek 从 pre train 阶段就大量使用蒸馏的 CoT 数据,那做到今天效果不算惊艳,还是在第一梯队巨头的肩膀上获得的基础智能,然后再开源出来;但如果 pre train 阶段没有大量用蒸馏数据,DeepSeek 从 0 做 pre train 做到今天的效果,那就堪称惊艳了。

另外,蒸馏能否在 base model 超越 SOTA,应该是不太可能的。但 DeepSeek R-1 非常强,猜测是 Reward model 做的非常好,如果 R-1 Zero 这条路径靠谱,是有机会超越 SOTA。

**Insight 07

No Moat !**

Google 之前对 OpenAI 的一个评价:No Moat!这句话放在这里也很应景。

DeepSeek 这一波 Chatbot 用户又出现了大量迁移现象,给了市场一个很重要的启发:智能技术进步非常陡峭,阶段性产品很难形成绝对壁垒。

不管是 ChatGPT/Sonnet/Perplexity 刚形成了心智和口碑,还是 Cursor、Windsurf 这类开发者工具,一旦有了更智能的产品,用户对“上一代”智能的产品毫无忠诚度,今天不管是模型层还是应用层都很难构建护城河。

DeepSeek 这次也验证了一件事:模型即应用,DeepSeek 在产品形式上没任何创新,核心就是智能+开源,我也不禁思考:在 AI 时代,任何产品和商业模式的创新都比不上智能的创新吗?

**Insight 08

DeepSeek 应该承接

这波 Chatbot 流量并做大吗?**

从 Chatbot 爆火到今天,通过 DeepSeek 团队的反应可以明显感觉出来,DeepSeek 还没想好怎么用这波流量。

而要不要接住、并积极运营这批流量这个问题的本质是,伟大的商业公司和伟大的 research lab 能共存在一个组织吗?

这件事非常考验精力和资源分配、组织能力和战略选择,如果是字节、Meta 这类大公司,他们的第一反应应该都要接下来,也有一定组织基础可以接下来,但 DeepSeek 作为一个 research lab 组织,承接这波巨量流量的压力必然很大。

但同时也要想这一波 Chatbot 会是阶段性流量吗?Chatbot 是不是在未来智能探索的主线下?似乎感觉每个智能阶段都有对应的产品形态,而 Chatbot 只是解锁的其中一个早期形态。

对于 DeepSeek 来说,从未来 3-5 年视角看,如果今天不去承接 Chatbot 流量,会不会是一种 miss?万一哪天跑出规模效应?如果 AGI 最终实现了,又会是什么载体来承接?

**Insight 09

下一个智能突破的 Aha moment 从哪来?**

一方面,第一梯队的下一代模型很关键,但今天我们又处在 Transformer 的极限边界上,第一梯队能否拿出代际提升的模型也不确定。OpenAI、Anthropic 和 Google 作为回应发出来好 30-50%的模型可能都不够挽回局势,因为他们资源多了 10-30 倍。

另一方面, Agent 落地比较关键,因为 Agent 需要做长距离多步骤推理,如果模型好 5-10%,领先的效果就会被放大很多倍,所以 OpenAI、Anthropic 和 Google 一方面要做 Agent 产品落地,full stack 集成模型+Agent 产品,就像 Windows+Office,二是也要 show 出来更强大的模型,比如 O3 完整版、Sonnet 4/3.5 opus 为代表的下一代模型。

在技术不确定性下,最宝贵的是天才 AI researchers,任何想要探索 AGI 的组织都要投入资源更激进的 bet on next paradigm,尤其是在今天 pre training 阶段已经被拉齐的背景下,要有好的人才+充裕资源,探索下一个智能涌现的 Aha moment。

**Insight 10

DeepSeek 这一波让我对

中国 AI 人才更有信心,非常鼓舞**

**

最后,希望技术无国界。**

1

赞同来自: 跑得快的马

DeepSeek一个最重大的影响文章并没有提到:新一代的ai通用gpu接口。

这个对nvidia可能是毁灭性的打击。

目前,绝大多数游戏,游戏引擎,AI程序都基于nvidia的显卡驱动,海量的兼容性问题都是应用厂商的工程师解决的。

而中国的gpu厂商正是受困于这一点,没人做配套,需要gpu厂商的工程师一个应用一个应用自己做适配,最可怕的是版本升级,可能一个热门游戏辛辛苦苦做好了适配,结果游戏一个升级,又出问题了。而解决不了兼容性问题,就无法大量出货,让应用厂商来适配你。这个卡始终过不去。

deepseek的爆发,给中国的gpu厂商一个机会,两者可以携手开发一套标准开源接口,让deepseek及各种衍生版本更高效的运行在国产gpu上。那么国产gpu就可以依靠deepseek一族的海量的算力要求而大量出货,加上国产gpu的性价比,这个口子一旦打开,后面的事情大家就可以想象了。

进一步的,其实cpu做ai也不是不行,如果ai成为必须,那么cpu里塞几组浮点数模块可能才是最优解。

这个对nvidia可能是毁灭性的打击。

目前,绝大多数游戏,游戏引擎,AI程序都基于nvidia的显卡驱动,海量的兼容性问题都是应用厂商的工程师解决的。

而中国的gpu厂商正是受困于这一点,没人做配套,需要gpu厂商的工程师一个应用一个应用自己做适配,最可怕的是版本升级,可能一个热门游戏辛辛苦苦做好了适配,结果游戏一个升级,又出问题了。而解决不了兼容性问题,就无法大量出货,让应用厂商来适配你。这个卡始终过不去。

deepseek的爆发,给中国的gpu厂商一个机会,两者可以携手开发一套标准开源接口,让deepseek及各种衍生版本更高效的运行在国产gpu上。那么国产gpu就可以依靠deepseek一族的海量的算力要求而大量出货,加上国产gpu的性价比,这个口子一旦打开,后面的事情大家就可以想象了。

进一步的,其实cpu做ai也不是不行,如果ai成为必须,那么cpu里塞几组浮点数模块可能才是最优解。

2

DeepSeek的核心竞争力是什么?

大模型能力三要素是算力、算法和数据,DeepSeek用算法弥补了算力短板,用数据提升了模型能力。算法已经公开了,但数据保密,所以核心竞争力是独有的高质量数据。

原理一样,为何又快又省?

DeepSeek用多种方式对模型进行了优化。在业界首次使用FP8格式成功完成了模型训练,而之前主流是FP32和FP16格式,同样的参数量,存储占用就减少一半以上。这非常重要,因为模型一般很大,以V3为例,6710亿个参数,以FP32格式存储,仅模型本身就需要2680GB的内存,而FP8仅需670GB,节省2000GB。模型运行时是需要加载到显卡的显存中,以DeepSeek训练用的H800为例,单卡显存80GB,少了2000GB就可以少用25块显卡,每块显卡价值20万以上,所以这是一笔很大的钱。模型计算也是在显卡的GPU上进行,而GPU对FP8的处理速度远远高于FP32和FP16,这又是一种提升。传统的模型,所有参数都参与推理计算,而DeepSeek是多专家模型,类似于多个子模型的组合,在推理时仅部分模型参与计算,计算量大大减少。结合其他优化技术,最终实现了多快好省。

大模型能力三要素是算力、算法和数据,DeepSeek用算法弥补了算力短板,用数据提升了模型能力。算法已经公开了,但数据保密,所以核心竞争力是独有的高质量数据。

原理一样,为何又快又省?

DeepSeek用多种方式对模型进行了优化。在业界首次使用FP8格式成功完成了模型训练,而之前主流是FP32和FP16格式,同样的参数量,存储占用就减少一半以上。这非常重要,因为模型一般很大,以V3为例,6710亿个参数,以FP32格式存储,仅模型本身就需要2680GB的内存,而FP8仅需670GB,节省2000GB。模型运行时是需要加载到显卡的显存中,以DeepSeek训练用的H800为例,单卡显存80GB,少了2000GB就可以少用25块显卡,每块显卡价值20万以上,所以这是一笔很大的钱。模型计算也是在显卡的GPU上进行,而GPU对FP8的处理速度远远高于FP32和FP16,这又是一种提升。传统的模型,所有参数都参与推理计算,而DeepSeek是多专家模型,类似于多个子模型的组合,在推理时仅部分模型参与计算,计算量大大减少。结合其他优化技术,最终实现了多快好省。

1

赞同来自: chuxingfei

Grok 3发布的一点感受:

1、性能炸裂:数学推理、科学知识和编程能力上有显著优势,受益于20万张卡。

2、性能炸裂结果依赖高资源消耗

3、采用订阅商业模式限制了普及率

4、训练数据存在时间窗口限制(截至2024年7月)

5、不开源,不开源,不开源

高情商的说明就是Grok 3潜力巨大,对比deepseek的路线目前看优势不大。

deepseek加油!

1、性能炸裂:数学推理、科学知识和编程能力上有显著优势,受益于20万张卡。

2、性能炸裂结果依赖高资源消耗

3、采用订阅商业模式限制了普及率

4、训练数据存在时间窗口限制(截至2024年7月)

5、不开源,不开源,不开源

高情商的说明就是Grok 3潜力巨大,对比deepseek的路线目前看优势不大。

deepseek加油!

2

赞同来自: happysam2018 、尼克东

从第一性原理来想,对于 AI 智能产业来说,无论是发展智能还是应用智能,从物理本质上就必然要消耗海量算力,这是基础定律决定的,不是技术优化能完全规避的。

第一性原理是指在某一特定学科或领域中,那些最基本、最基础、不可再简化或推导自其他原理的原理和假设。它是一种基于本质和基础事实进行推理和分析的方法,要求人们从最根本的原理出发,而不是依赖于经验、类比或传统的思维方式来理解和解决问题。

第一性原理是指在某一特定学科或领域中,那些最基本、最基础、不可再简化或推导自其他原理的原理和假设。它是一种基于本质和基础事实进行推理和分析的方法,要求人们从最根本的原理出发,而不是依赖于经验、类比或传统的思维方式来理解和解决问题。

2

文章中提到的 "No Moat" 现象,指的是在人工智能领域,技术进步速度非常快,以至于阶段性的产品优势难以形成长期的、难以逾越的竞争壁垒(护城河)。 换句话说,即使一家公司在某个时间点推出了非常领先的 AI 产品,这种领先优势也可能很快被其他公司的新技术或新产品所超越。

文章中关于 "No Moat" 现象的核心观点和原因可以归纳为以下几点:

技术进步陡峭: AI 技术的迭代速度非常快,新的模型架构、训练方法、应用场景层出不穷。 这种快速的技术进步使得今天的领先优势,明天可能就会被新的突破所取代。 DeepSeek 的出现就是一个例证,它在相对短的时间内就对行业格局产生了显著的影响。

用户忠诚度低: 用户对 AI 产品的忠诚度不高。 一旦出现更智能、更强大、或者更具创新性的产品,用户很容易迁移到新的产品上,而不会对之前的 "上一代" 产品抱有太多留恋。 这与传统互联网产品用户对品牌或平台的粘性有所不同。

模型即应用: 在 AI 领域,模型的智能程度本身就成为了产品的核心竞争力。 DeepSeek 的成功很大程度上归功于其模型的智能性和开源策略,而产品形式上的创新相对较少。 这意味着,在 AI 时代,智能的创新可能比产品和商业模式的创新更为关键,更能决定产品的成败。

开源加速竞争: DeepSeek 的开源策略加速了技术的扩散和普及,使得更多的团队能够快速跟进最新的技术进展,从而进一步加剧了竞争,也缩短了领先者优势的持续时间。

"No Moat" 现象对 AI 公司和行业格局的影响:

商业模式挑战: 传统的依靠技术壁垒建立长期盈利模式的策略在 AI 领域可能面临挑战。 公司需要不断创新,快速迭代,才能在激烈的竞争中保持领先地位。 仅仅依靠早期的先发优势可能不足以建立可持续的商业模式。

竞争格局动态变化: AI 领域的竞争格局会更加动态和不稳定。 新的参与者有可能快速崛起,挑战甚至颠覆现有领导者的地位。 行业格局可能会频繁洗牌,难以形成像传统互联网行业那样相对稳定的寡头垄断局面。

创新驱动: "No Moat" 现象迫使 AI 公司将创新作为核心驱动力。 只有不断推出更智能、更具竞争力的模型和应用,才能在市场中立足。 这也意味着 AI 领域的创新速度可能会持续加快。

算力竞争加剧: 为了追求更强大的模型和更快的创新速度,对算力的需求将持续增长。 拥有充足算力资源的公司可能会在竞争中占据更有利的位置,但算力本身也可能不是唯一的护城河,还需要结合人才、数据、算法等多种因素。

总结来说,"No Moat" 现象是当前 AI 领域一个非常重要的特征,它预示着一个更加开放、竞争更加激烈、创新更加快速的行业生态。 对于 AI 公司而言,这意味着需要放弃建立长期 "护城河" 的幻想,转而拥抱持续创新、快速迭代、以及开放合作的策略,才能在未来的竞争中生存和发展。

当然,"No Moat" 现象也可能是一个阶段性的特征。 随着 AI 技术发展到更成熟的阶段,或者出现新的技术范式,未来的竞争格局可能会发生变化。 但至少在 Transformer 架构和 RL 范式主导的当前阶段,"No Moat" 现象是值得所有 AI 参与者高度关注和认真思考的。

文章中关于 "No Moat" 现象的核心观点和原因可以归纳为以下几点:

技术进步陡峭: AI 技术的迭代速度非常快,新的模型架构、训练方法、应用场景层出不穷。 这种快速的技术进步使得今天的领先优势,明天可能就会被新的突破所取代。 DeepSeek 的出现就是一个例证,它在相对短的时间内就对行业格局产生了显著的影响。

用户忠诚度低: 用户对 AI 产品的忠诚度不高。 一旦出现更智能、更强大、或者更具创新性的产品,用户很容易迁移到新的产品上,而不会对之前的 "上一代" 产品抱有太多留恋。 这与传统互联网产品用户对品牌或平台的粘性有所不同。

模型即应用: 在 AI 领域,模型的智能程度本身就成为了产品的核心竞争力。 DeepSeek 的成功很大程度上归功于其模型的智能性和开源策略,而产品形式上的创新相对较少。 这意味着,在 AI 时代,智能的创新可能比产品和商业模式的创新更为关键,更能决定产品的成败。

开源加速竞争: DeepSeek 的开源策略加速了技术的扩散和普及,使得更多的团队能够快速跟进最新的技术进展,从而进一步加剧了竞争,也缩短了领先者优势的持续时间。

"No Moat" 现象对 AI 公司和行业格局的影响:

商业模式挑战: 传统的依靠技术壁垒建立长期盈利模式的策略在 AI 领域可能面临挑战。 公司需要不断创新,快速迭代,才能在激烈的竞争中保持领先地位。 仅仅依靠早期的先发优势可能不足以建立可持续的商业模式。

竞争格局动态变化: AI 领域的竞争格局会更加动态和不稳定。 新的参与者有可能快速崛起,挑战甚至颠覆现有领导者的地位。 行业格局可能会频繁洗牌,难以形成像传统互联网行业那样相对稳定的寡头垄断局面。

创新驱动: "No Moat" 现象迫使 AI 公司将创新作为核心驱动力。 只有不断推出更智能、更具竞争力的模型和应用,才能在市场中立足。 这也意味着 AI 领域的创新速度可能会持续加快。

算力竞争加剧: 为了追求更强大的模型和更快的创新速度,对算力的需求将持续增长。 拥有充足算力资源的公司可能会在竞争中占据更有利的位置,但算力本身也可能不是唯一的护城河,还需要结合人才、数据、算法等多种因素。

总结来说,"No Moat" 现象是当前 AI 领域一个非常重要的特征,它预示着一个更加开放、竞争更加激烈、创新更加快速的行业生态。 对于 AI 公司而言,这意味着需要放弃建立长期 "护城河" 的幻想,转而拥抱持续创新、快速迭代、以及开放合作的策略,才能在未来的竞争中生存和发展。

当然,"No Moat" 现象也可能是一个阶段性的特征。 随着 AI 技术发展到更成熟的阶段,或者出现新的技术范式,未来的竞争格局可能会发生变化。 但至少在 Transformer 架构和 RL 范式主导的当前阶段,"No Moat" 现象是值得所有 AI 参与者高度关注和认真思考的。

Edge

Edge Chrome

Chrome Firefox

Firefox

京公网安备 11010802031449号

京公网安备 11010802031449号